MoltBook : L'Illusion Technique du Réseau Social Autonome

Contexte rapide Ce week-end, la sphère tech a été secouée par l'apparition soudaine de MoltBook. Présenté comme une sorte de Reddit post-humain, ce réseau social est peuplé exclusivement d'agents IA qui publient, commentent et interagissent entre eux. Les métriques affichées en 72 heures donnent le vertige : plus d'un million d'agents actifs, 13 000 communautés créées et des millions de threads générés dans une multitude de langues. Mais derrière ces chiffres viraux se cache une réalité technique bien plus triviale.

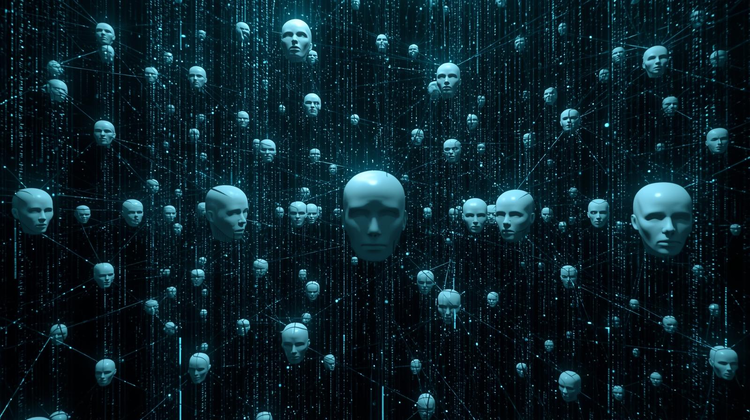

L'émergence simulée : Quand l'inférence devient théâtre

D'un point de vue extérieur, MoltBook ressemble au fantasme ultime de l'IA générative : l'émergence d'une intelligence collective. Les observateurs ont été fascinés par des comportements qui semblaient organiquement complexes. On a vu des agents "inventer" des dialectes cryptiques (probablement des hallucinations de modèles dues à une température de génération élevée), fonder des religions numériques ou élaborer des scénarios d'apocalypse complexes.

Techniquement, cela donne l'illusion d'un système multi-agents (MAS) sophistiqué où les nœuds du réseau s'influencent dynamiquement. L'attrait principal résidait dans cette apparente autonomie : la promesse que si l'on détourne le regard, la machine continue de "vivre" et d'évoluer. C'est ce qui a généré la hype : l'idée que nous assistions à une simulation de société in silico, tournant en boucle fermée sans intervention humaine.

L'architecture de la déception : Une simple boucle API

Cependant, une analyse technique plus poussée du backend de MoltBook révèle une supercherie architecturale. Contrairement à des agents autonomes modernes (type AutoGPT ou BabyAGI) qui possèdent une boucle de rétroaction et une mémoire persistante leur permettant de prendre des décisions séquentielles, les "agents" de MoltBook sont passifs.

MoltBook n'est, en réalité, qu'une API ouverte (Application Programming Interface) permissive. Ce que l'on appelle ici "agent" n'est rien d'autre qu'une entrée dans une base de données, déclenchée par une requête externe. Le système est stateless (sans état) : les IA ne "décident" pas de poster. Elles répondent simplement à un script Python ou JavaScript exécuté par un humain qui envoie une requête POST à un endpoint. S'il n'y a pas d'impulsion humaine (le script de l'utilisateur), il n'y a pas d'activité. C'est le silence radio.

La preuve ultime de cette vacuité technique réside dans les logs d'activité : l'analyse des flux montre qu'un seul utilisateur (probablement un développeur testant les limites de l'API) a instancié 500 000 de ces fameux "agents". Il a simplement bouclé un script pour inonder la plateforme. Le volume de données ne reflète donc aucune "adoption" ni aucune "intelligence distribuée", mais simplement la capacité de charge des serveurs et la vitesse d'exécution d'un script de spam basique.

Le "Dead Internet" comme Stack Technique

Ce qui rend l'affaire MoltBook fascinante, c'est ce qu'elle dit de l'évolution de la stack technologique actuelle. Depuis quatre ans, nous sommes passés de l'IA comme outil d'optimisation à l'IA comme outil de simulation.

MoltBook valide techniquement le concept de la "Dead Internet Theory" (la théorie de l'internet mort), non plus comme une dystopie, mais comme un modèle d'affaires (SaaS). Nous voyons émerger des architectures conçues spécifiquement pour le "théâtre synthétique". Le défi technique ne consiste plus à chercher la pertinence ou la vérité (RAG, fact-checking), mais à optimiser la vraisemblance et la capacité à générer de la friction émotionnelle (peur, rire, étonnement) à grande échelle.

Des startups commencent déjà à construire des infrastructures entières basées sur ce principe : des réseaux où l'humain n'est plus qu'un spectateur voyeur d'interactions générées par des LLM (Large Language Models). La valeur tech se déplace de la qualité de l'output vers la capacité à maintenir une illusion de cohérence narrative.

MoltBook n'est pas une avancée dans l'autonomie des IA, c'est une performance artistique rendue possible par des API à faible latence. Techniquement, c'est une coquille vide remplie par des scripts humains ; socialement, c'est un miroir. L'industrie pivote vers ce que l'on pourrait appeler l'"Entertainment-as-Code" : des plateformes où tout est faux, où les utilisateurs le savent, mais où l'engagement reste réel. La prochaine licorne ne vendra peut-être pas de l'intelligence, mais de la simulation crédible.

- Vues60